OpenAI : GPT‑oss‑120B & 20B : IA open source • BaskTech

Célèbre le grand retour de l’open source en lançant gpt‑oss‑120b et gpt‑oss‑20b, ses premiers modèles open‑weight depuis GPT‑2 (2019). Ces modèles sont disponibles sous licence Apache 2.0, sans restriction commerciales, et offrent aux développeurs, TPE/PME, professions libérales et institutions publiques une autonomie totale : exécution locale, possibilité d’affinage (fine‑tuning), déploiement sur site, sans frais ou abonnement payant .

Pourquoi ces modèles open source révolutionnent l’IA?

🏗️ Architecture technique et fonctionnalités principalesStructure des modèles (Mixture‑of‑Experts)

- gpt‑oss‑120b : environ 117–120 milliards de paramètres, avec 36 couches, 128 experts par couche, dont 4 sont activés par token → cela réduit le coût d’inférence tout en assurant un raisonnement puissant .

- gpt‑oss‑20b : 21 milliards de paramètres, avec 24 couches, 32 experts par couche et 4 actifs par token .

gpt‑oss‑120B vs gpt‑oss‑20B : capacité et performances:

Optimisations techniques

- Attention alternée dense/sparse, mise en œuvre de Rotary Positional Embedding (RoPE), grouped multi-query attention (groupe de taille 8), et précision 4‑bits MXFP4 pour l’inférence .

- Contexte de 128 000 tokens : permet de traiter jusqu’à 300–400 pages en une seule requête, idéal pour des documents longs ou des workflows RAG (retrieval‑augmented generation) .

⚙️ Capabilités d’usage : raisonnement, outils et agents intégrés

- Les deux modèles supportent le chain-of-thought reasoning (CoT) et l’appel de fonctions (fonction calling), ce qui les rend adaptés à des tâches complexes, de l’analyse juridique à l’assistance comptable automatisée .

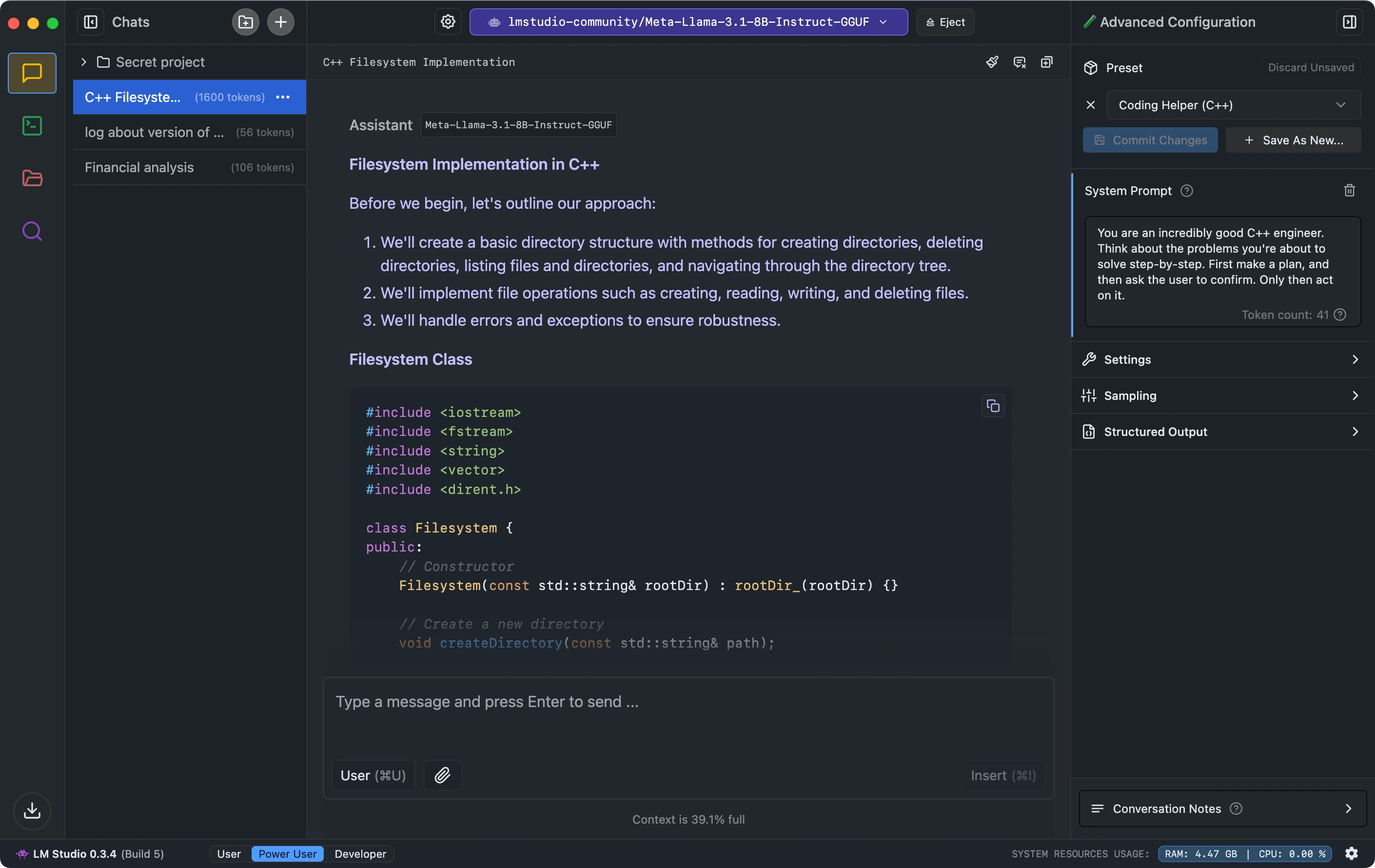

- Compatibilité étendue d’intégration : Hugging Face, Azure AI Foundry, AWS, Databricks, Cloudflare, Vercel… ils peuvent être utilisés avec des interfaces comme Ollama, LM Studio, ou des modules Docker pour exécuter des navigateurs ou interpréteurs Python (via Exa API) .

- Niveau de raisonnement configurable (low, medium, high) selon priorités latence/performance.

📊 Performance comparée à d’autres modèles OpenAI

| Modèle | Taille effective (GIF) | Évaluation benchmark | Score GPQA Diamond |

| gpt‑oss‑120b | ≈ 117 B total / 5.1 B token actif | Comparable à o4‑mini, très proche de GPT‑4o | ~ 80 % (vs 83 % pour o3) |

| gpt‑oss‑20b | ≈ 21 B total / 3.6 B token actif | À niveau du o3‑mini, voire supérieur sur certains tests | ~ 71–77 % selon benchmark |

Benchmarks spécialisés :

- Codeforces : gpt‑oss‑120b atteint les performances d’OpenAI o3.

- Humanity’s Last Exam (HLE) : ~ 19 % pour gpt‑oss‑120b vs 24,9 % pour o3 avec outils.

- GPQA Diamond : gpt‑oss‑120b ~ 80 % vs 83 % avec o3, gpt‑oss‑20b ~ 71 %.

Au global, ces modèles offrent une performance proche ou parfois dépassant les modèles propriétaires de taille similaire.

- Sécurité, licence Apache et alignement avec les enjeux régionaux?

🔐 Sécurité et audits rigoureux OpenAI a soumis les modèles à des protocoles de sécurité complets :

- Suppression proactive de données sensibles durant l’entraînement (chimiques, biologiques, cybersécurité).

- Entraînements adverses (malicious fine‑tuning) pour tester les dérives potentielles.

- Collaboration avec SecureBio, et cadrage via le Preparedness Framework : même dans des scénarios hostiles, gpt‑oss‑120b reste en dessous des seuils critiques, même après fine‑tuning malveillant .

🎯 Pourquoi OpenAI redevient open source

- Face à la concurrence croissante des modèles chinois (DeepSeek, Qwen 3) ou européens (Mistral, Meta LLaMA, GLM‑4.5), OpenAI veut préserver son leadership tout en démocratisant l’accès .

- Stratégie hybride :

- Gratuits & libres pour les développeurs et chercheurs.

- Services payants de fine-tuning, déploiement sécurisé et support pour entreprises.

🚀 Cas d’usage pour les professions libérales et TPE/PMEPour les cabinets de conseils, experts-comptables, avocats ou formateurs :

- Automatisation de la rédaction (rapports complexes, synthèses juridiques, comptes rendus médicaux).

- Assistant agentif local : exécution de code ou d’appels API, recherche web via navigateur intégré, workflow autonome sans connexion cloud.

- Confidentialité garantie : les données restent en local ou derrière un firewall, hors cloud public.

- Customisation : affinez sur vos données métier (contrats, dossiers patients…), déployez dans un environnement compliance/non-cloud.

Pour les agences web ou intégrateurs no-code (comme avec Webflow) :

- Intégrez gpt‑oss dans des flux automatisés via APIs internes.

- Développez des outils générateurs de contenu SEO, support client automatisé, agents intelligents.

- Profitez d’un contexte long (128 k tokens) pour gérer de grands documents ou bases de connaissances.

🧩 Déploiement et disponibilité

- Téléchargement libre sur Hugging Face (gpt‑oss‑120b et 20b), GitHub pour les tokenizers et modèles de référence .

- Disponibles sur Azure AI Foundry, Windows AI Foundry (bientôt MacOS), Databricks, AWS/GCP via Foundation Model API .

OpenAI lance également un programme Red‑Teaming de 500 000 USD sur Kaggle, avec publication des rapports et données d’évaluation pour promouvoir la recherche open source en sécurité IA .

⚠️ Limitations & critiques observées Des retours récents (notamment sur Reddit) mentionnent des critiques : “Underwhelmed… excessive censorship, high hallucination rates, performance worse que Llama 4 V2, K2, DeepSeek V3” .

Il est crucial de réaliser vos propres évaluations sur les cas d’usage spécifiques avant un déploiement productif. En conclusion, gpt‑oss‑120b et gpt‑oss‑20b incarnent une étape majeure vers une IA réellement accessible, transparente et performante pour les professionnels.

L’architecture avancée (MoE), la licence permissive, la compatibilité avec un vaste écosystème technique, et une couverture sécurité rigoureuse en font des outils puissants pour automatiser, raisonner, coder et déployer localement, tout en préservant confidentialité et contrôle.

Si vous souhaitez un accompagnement spécifique pour : La BaskTech peut vous proposer une stratégie technique professionnelle complète, adaptée à votre cas d’usage.

- Déployer un agent local ou cloud‑privé

- Effectuer un fine‑tuning sur données métiers

- Intégrer dans un écosystème no-code ou Webflow

- Architecturer un workflow automatisé agent‑ique